Die großen Internet-Konzerne und ihre Arbeitsweise geraten derzeit zu Recht in die Diskussion. Jahrelang haben sie sich mit dem Verweis auf ihre Algorithmen aus der Verantwortung gestohlen. Aber das Versagen dieser Plattformen ist auch ein Lernprozess. Denn was richten Plattformen und Suchmaschinen eigentlich an, wenn sie immer mehr persönliche Daten auslesen und die Nutzer in ihren Blasen einschließen? Wer bekommt also welche Ergebnisse? Thema für eine Studie mit reger Beteiligung.

Vorgestellt werden deren Zwischenergebnisse am Mittwoch, 28. Februar, in Berlin, im Rahmen einer Fachveranstaltung in der Bayerischen Vertretung in Berlin. Im Mittelpunkt steht der Suchmaschinendienst Google. Einer von diesen Giganten, denen man unterstellt, sie würden mit ihren Algorithmen die Ergebnisse für die Nutzer derart personalisieren, dass kaum noch zwei Nutzer dasselbe Ergebnis zu sehen bekommen.

Vielleicht ist da eine weltweit erfolgreiche Suchmaschine nicht gerade der geeignete Untersuchungskandidat. Denn eine Suchmaschine, die nicht wirklich relevante und seriöse Ergebnisse liefert, ist eigentlich nicht vertrauenswürdig, oder?

Eine gute Frage. Die die Forscher, die die Studie erstellt haben, zumindest zugunsten von Google auslegen.

Worum ging es?

Zwei Internetnutzer, die während des Bundestagswahlkampfs mit Googles Nachrichtensuchmaschine Google News nach deutschen Politikern oder Parteien gesucht haben, haben im Durchschnitt bei 20 Suchergebnissen 15 identische erhalten. Zugleich teilten sich 20 bis 30 Prozent der Nutzerpaare höchstens die Hälfte der angezeigten Nachrichtentreffer. Dies geht aus dem zweiten Zwischenbericht der Informatik-Professorin Dr. Katharina Anna Zweig von der Technischen Universität Kaiserslautern zum Forschungsprojekt „#Datenspende: Google und die Bundestagswahl 2017“ im Auftrag von sechs Landesmedienanstalten hervor.

Die Ergebnisse der Studie könnten durchaus ein Beginn und eine erste Grundlage für eine mögliche gesellschaftliche Kontrolle von Algorithmen werden.

Prof. Dr. Rüdiger Steinmetz, Mitglied des Medienrates der Sächsischen Landesanstalt für privaten Rundfunk und neue Medien (SLM), sagt dazu: „Der Studie ist es gelungen, einen ersten Einblick in die ‚Black Box‘ des Algorithmus bei Google und Google News zu erlangen: Begünstigt eine personalisierte und damit selektive Nachrichtenanzeige die Herausbildung von Filterblasen? Mit Hilfe der Ergebnisse kann eine dauerhafte, automatisierte Beobachtung dieser für unsere Demokratie zentral wichtigen, bisher undurchschaubaren Informations-Prozesse etabliert werden.“

Für die Studie haben die Landesmedienanstalten und mehrere beteiligte Medien Freiwillige gesucht, die bereit waren, zu festgelegten Zeiten die Namen von bekannten Politikern und Parteien in ihre Suchmaske bei Google und bei Google News einzugeben. Die Suchmaschine spuckt ja dann bekanntlich tausende, bei bekannten Namen auch mal Millionen Ergebnisse aus. Diese werden direkt aus der riesigen Bibliothek ausgelesen, die die Crawler, die Google regelmäßig ausschickt, um die neuesten Nachrichten und Veröffentlichungen im Netz zu erfassen, zusammengetragen haben.

Eigentlich eine geniale Idee

Ohne solche Suchmaschinen, die permanent das ganze Netz durchkämmen, wären wir im Internet regelrecht orientierungslos. Wir würden nicht finden, was wir suchen – auch weil wir uns gar nicht alle Internetadressen merken können. Wir wären auch orientierungslos, wenn Google, Yahoo, Bing und wie die anderen Maschinen sonst noch heißen, alle Ergebnisse wahllos und ungewichtet ausspucken würden. Was sie nicht tun. Sie sortieren alle Ergebnisse nach Relevanz (wie seriös und zuverlässig sind bestimmte Quellen und wie vertrauenswürdig) und nach Aktualität.

Wie sie das tun, verraten sie manchmal. Aber in Gänze legen sie ihre Algorithmen und die Ordnungskriterien nie vor.

Aber die Reihenfolge ist Gold wert

Denn wirklich angeklickt werden fast ausschließlich die ersten 10 Suchergebnisse, die Google auf der ersten Ergebnisseite veröffentlicht. Kaum ein Nutzer blättert sich durch die nächsten Seiten. Das ist für Nachrichtenmedien genauso wichtig wie für Werbetreibende. Wer sofort gefunden wird, bekommt Reichweite und Umsatz. Der Rest schaut in die Röhre.

Wäre es aber nur das, würden alle Google-Suchergebnisse zum selben Zeitpunkt immer gleich aussehen. Jeder der über 4.000 Tester, die ihre Suchergebnisse als „Datenspende“ bereitgestellt haben, müsste dieselben 10 oder 20 Top-Ergebnisse erzielt haben.

Das war aber nicht der Fall. Denn auch bei Google werden Suchergebnisse personalisiert. Das heißt: Vorlieben, Wohnort, Nutzergewohnheiten – all die Spuren, die ein Google-Nutzer im Internet hinterlässt, fließen als Schablone in das Suchergebnis mit ein. Das heißt: Manche Suchergebnisse schätzt die Suchmaschine als für den Nutzer relevanter ein – und listet sie höher.

Jetzt können sich die Forscher streiten

Bedeuten im Schnitt 14,33 gleiche Ergebnisse von 20 Top-Treffern bei den abgefragten Parteien einen hohen Grad an Beeinflussung für die Nutzer oder einen geringen? Und warum gab es bei den nachgefragten Spitzenkandidaten mit 15,87 übereinstimmenden Suchergebnissen ein etwas besseres Ergebnis?

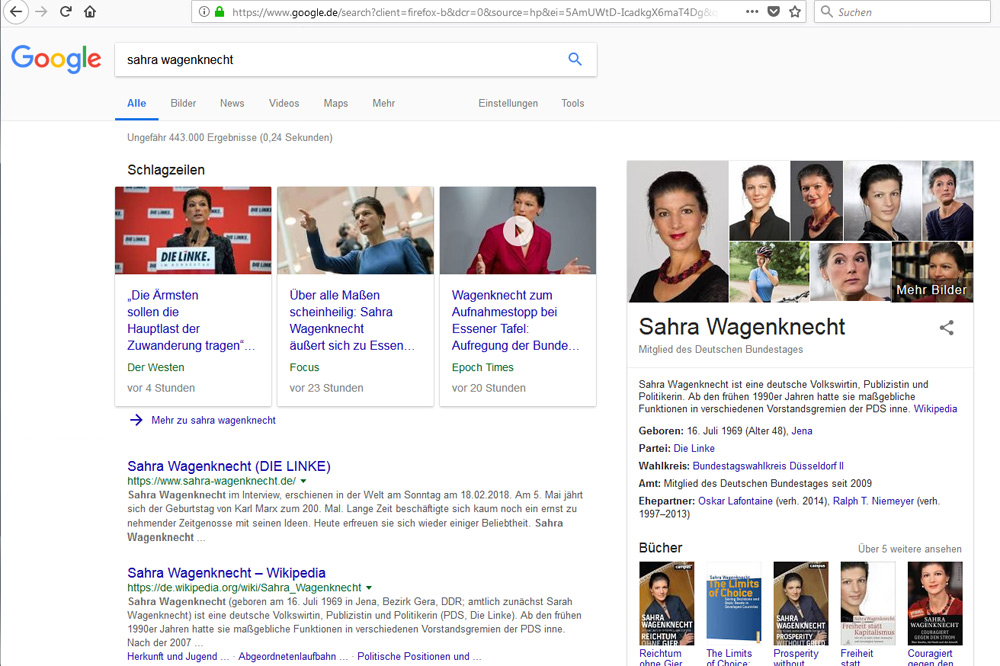

Und was bedeutet es, wenn für Sahra Wagenknecht (Linke) die Übereinstimung der Ergebnisse mit durchschnittlich 16,99 deutlich höher ist als bei Angela Merkel(CDU) mit 14,36?

Als kritischer Beobachter könnte man sagen: Das alles dürfte gar nicht sein. Denn die personifizierten Suchergebnisse sind eine deutliche Beeinflussung des Nutzers: Er bekommt eben keine nach für alle gleichen Relevanz sortierten zuverlässigen Ergebnisse, sondern verzerrte. Er bekommt also schon eine Auswahl, die ihm die Sicht auf die Welt nicht objektiviert, sondern subjektiviert.

Die Suchmaschine tendiert zur Filterblase

Google hat – so gesehen – das Pech, dass man eine Suchmaschine vergleichend auslesen kann. Bei Nutzernetzwerken wie Facebook ist das schlicht unmöglich. Aber da wird das Thema ja erst richtig brisant: Wie informiert können Nutzer eigentlich mitdiskutieren, wenn ihnen bestimmte Informationen durch den Algorithmus dauerhaft vorenthalten werden? Wenn ihm der Algorithmus suggeriert: „Das ist das, was du darüber wissen kannst und musst …“ – Aber einen wichtigen Ausschnitt der relevanten Informationen bekommt er gar nicht erst zu sehen?

Da werden die Teilnehmer des Fachtages also so einiges zu diskutieren haben. Denn beruhigend sind die Studienergebnisse ganz und gar nicht. Denn eine Frage zum Beispiel beantwortet die Studie nicht: Stehen wirklich alle relevanten Informationsquellen auf der ersten Ergebnisseite? Oder tauchen wichtige Quellen hier gar nicht auf, weil sie den Ausleseformeln von Google nicht genügen?

Das Forschungsprojekt #Datenspende wird finanziert von den Landesmedienanstalten Bayern (BLM), Berlin-Brandenburg (mabb), Hessen (LPR Hessen), Rheinland-Pfalz (LMK), Saarland (LMS) und Sachsen (SLM) und durchgeführt in Kooperation mit der gemeinnützigen Initiative für die Kontrolle algorithmischer Entscheidungsfindung AlgorithmWatch sowie der TU Kaiserslautern.

Warum so eilig oder Wie wird man wieder Herr seiner Zeit? – Die neue LZ Nr. 52 ist da

So können Sie die Berichterstattung der Leipziger Zeitung unterstützen:

Keine Kommentare bisher