This article is also available in English: Read this article in English.

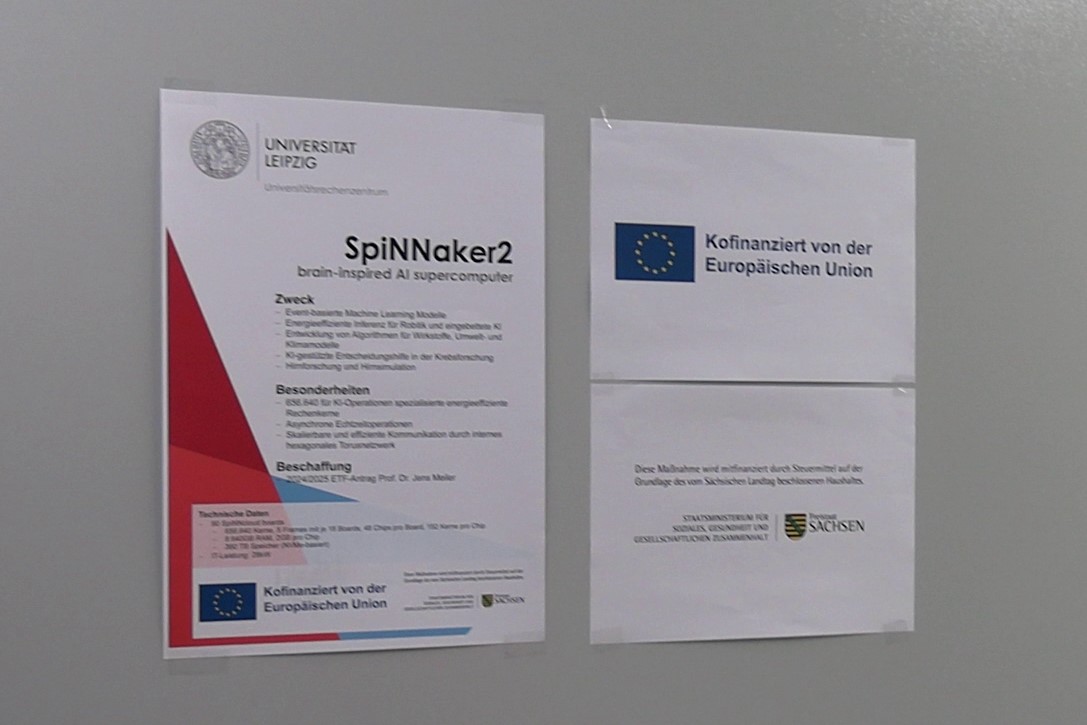

Am 28. Oktober stellte die Universität Leipzig ihren neuen, vom Gehirn inspirierten, Supercomputer der Leipziger Presse vor. Bevor wir in die heiligen Hallen der Universität gehen durften, um SpiNNaker2 einmal zu sehen, gaben Prof. Dr. Jens-Karl Eilers, Prorektor für Forschung der Universität Leipzig, der Direktor des Universitätsrechenzentrums Dieter Lehmann, Prof. Dr. Jens Meiler, der Direktor des Instituts für Wirkstoffentwicklung und Prof. Dr. Christian Mayr von der TU Dresden, der auch Gründer des Chip-Start-up Spinncloud ist, uns einige kurze Einblicke und die Gelegenheit für Fragen.

Interessierte Menschen können weitere Informationen in der Pressemitteilung der Universität Leipzig finden.

Was hat es mit dieser Inspiration durch das Gehirn auf sich?

Dazu führte Prof. Mayr aus: „Gehirninspiration, sagen wir mal, passiert auf einem eher abstrakten Level. Man kann sich vorstellen, dass bei einer Computation (Berechnung) zum Beispiel, nicht ständig die Bits von hier drüben holen will und hier dann die Rechnung damit ausführen. Das braucht eine Menge Zeit, das braucht eine Menge Energie.

Das heißt, ein Konzept vom Gehirn ist halt wirklich Co-Location, dass ich die Berechnung und das Memory und die Kommunikation praktisch auf das absolut Nötige beschränke und so viel wie möglich praktisch verteilt in dem System mache. Das ist eines, wie wir dann auch das Drug Discovery (Medikamentenentwicklung) angehen, dann habe ich auch mehr Speicherbandbreite beispielsweise.

Dadurch, dass ich das verteilt hernehme, habe ich praktisch viele kleine Speicher und nicht den einen großen Speicher, der dann wieder ein Bottleneck (Flaschenhals) wird, der das Ganze wieder verlangsamt.“

So weit, so verständlich. Das gab mir Gelegenheit zu der Nachfrage: „Wenn ich es richtig verstehe, ist die Ähnlichkeit mit dem Gehirn darauf beschränkt, dass CPU und Speicher praktisch zusammen sitzen, dass es keine langen Wege gibt, dass die Daten an Ort und Stelle verarbeitet werden? Ich drücke es mal einfach aus.“

Prof. Mayr: „Genau, wir haben uns darauf konzentriert, nicht wie bei anderen solchen Ansätzen, die einzelne Neuronen und Synapsen nachbauen. Wir wissen eben teilweise noch zu wenig. Es gibt im Moment, wenn ich wieder aus KI-Sicht denke, keinen Trainingsalgorithmus, der so ein sehr detailliertes Computational Neuroscience-Model ähnlich gut trainiert wie ein KI-Model.

Das heißt, wir werden dieser Dynamik auch nicht Herr. Wir haben eher geschaut, was sind generelle Prinzipien des Gehirns und skalierbare Prinzipien, die auf so einer großen Maschine überhaupt funktionieren. Das ist eben, das ist die Co-Location auf jedem Niveau. Es macht Sinn praktisch auf dem Chip zu bleiben oder auf demselben Board oder auf demselben Frame, möglichst wenig praktisch Datenbewegungen zu generieren.“

Daraus resultiert auch die Energiesparsamkeit des Rechners. Auf diesen Aspekt wies auch Prof. Meiler hin: „Das ist ein wichtiger Punkt. Die Cluster, auf denen wir heute künstliche Intelligenz rechnen, brauchen wahnsinnig viel Energie und das wird zur Belastung. Und dieser Cluster ist nicht nur größer und schneller, sondern auch eben sehr, sehr energieeffizient.“

Das bestätigte auch Prof. Mayr: „Bei ganz normalen Sprachmodellen, sind wir im Moment im Faktor 18 energieeffizienter und im Faktor 3 schneller als ein NVIDIA-Board. Und NVIDIA ist nur wirklich optimiert eigentlich auf diese Modelle.“

Was macht den Supercomputer nun so besonders für die Wirkstoffentwicklung?

Prof. Mayr: „Das Gehirn macht ja nicht nur KI, das macht auch so eine Art Probabilistic Computing, also es rechnet mit Zufall, was Optimierungsverfahren sind. Das heißt, wir machen im Endeffekt wie mit Quantencomputern Wirkstoffentwicklungen, die eher aus der physikalischen Ecke kommen. Auf GPUs macht man die Wirkstoffentwicklungen eher aus der KI-Ecke.

Was wir hier drauf können, ist praktisch diese beiden Welten miteinander zu vereinen. Also das Beste aus beiden Welten, wir machen sehr genaue physikalische Modelle und sehr genaue KI-Modelle und können die durch diese Hirninspiration viel energieeffizienter und schneller dann auch abbilden.“

Um welche KI geht es eigentlich?

Ich habe nachgefragt, ob es um die Large Language Models (LLMs), wie Claude, Perplexity oder ähnliche geht.

Prof. Meiler: „Wir können auf diesem System auch LLMs trainieren, diese Large Language Models sind ja jetzt in aller Munde. Das ist aber nur eine Form der künstlichen Intelligenz. Das System ist hochflexibel und wir werden das auch für LLMs nutzen, aber auch für viele andere Anwendungen. Es gibt einen ganzen Zoo von Methoden der künstlichen Intelligenz. Diese Hardware ist so grundlegend designt, dass sie verschiedene Modelle der künstlichen Intelligenz unterstützen wird.“

Wie weit ist die Hardwareentwicklung im Vergleich zum Gehirn?

Prof. Meiler: „Wenn man sich das vorstellt, wir essen früh eine Banane oder einen Apfel, dann läuft das Gehirn, mit ganz wenig Energie. Jetzt kommen wir langsam in die Region, dass wir Systeme bauen können, die so groß sind. Aber selbst SpiNNacker braucht ja noch ein Vielfaches an Strom, verglichen mit dem menschlichen Gehirn, auch wenn er deutlich effizienter ist.“

Prof. Mayr: „Wir sind ungefähr auf der Mitte zwischen den GPUs und dem Gehirn, würde ich sagen. Also 10 hoch 3 Größenordnungen unterscheiden uns von den GPUs, aber uns unterscheiden immer noch 10 hoch 3 Größenordnungen vom Gehirn. Wir sind noch lange nicht da. Ich habe einen riesigen Respekt vor dem Gehirn, ehrlich gesagt. Wie effizient das ist.“

Es gab noch viele Ausführungen. Anwendung wird SpiNNacker2 in der Forschung, aber auch in der Lehre finden. Studierende werden damit arbeiten, besonders um ihre wissenschaftlichen Probleme so zu programmieren, dass sie mit dieser Hardware verarbeitet werden können. Auch die Unterstützung bei der Ausgründung aus der Universität ist Bestandteil der Arbeit.

Als bereits existierendes Beispiel wurde das Start-up „Artificial Intelligence Driven Therapeutics“, welches wir bereits vom MACHN-Festival kennen, angeführt. Ziel ist es, wie Prof. Meiler sagte: „Für die Region ist das eben auch eine große Chance, nicht nur hier die allerbesten und tollsten Studenten auszubilden, sondern vielleicht auch nicht nur ein, sondern 10 oder 20 oder 30 von diesen Start-ups hier in den nächsten Jahren zu etablieren, mit den wirklich guten Studenten, die wir hier an der Universität haben.“

Wie sieht SpiNNacker2 aus?

Auf ging es in den Serverraum und wie erwartet war es laut und SpiNNacker2 sieht eben wie jeder andere Server aus. Viele Kabel, blinkende Lichter – wer etwas optisch spektakuläres erwartete wurde wahrscheinlich enttäuscht. Aber auf jeden Fall war es irgendwie doch sehenswert.

Fazit: Es ist ein großer Schritt für die universitäre Lehre und Forschung und für den Standort Leipzig. Uns bleibt nur übrig, den Akteuren viel Erfolg zu wünschen und über den weiteren Werdegang zu berichten.

Empfohlen auf LZ

So können Sie die Berichterstattung der Leipziger Zeitung unterstützen:

Keine Kommentare bisher